Deepfake, czyli nie wierz nawet własnym oczom

Fałszywe wystąpienia angielskiej królowej Elżbiety II i przedstawicieli państw, sfabrykowane komunikaty służbowe, filmy pornograficzne wykorzystujące wizerunki hollywoodzkich gwiazd, jak na przykład Scarlet Johannson czy Jennifer Lawrence – to niektóre z zastosowań techniki obróbki obrazu powszechnie znanej jako Deepfake. Jest ona także wykorzystywana do przeprowadzania ataków związanych z zakupem kart podarunkowych – od początku pandemii wywołanej koronawirusem nastąpił wzrost liczby tego rodzaju ataków o 820 proc.

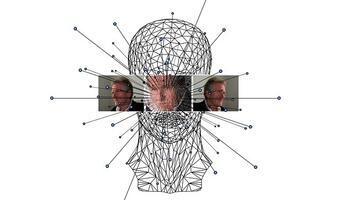

Deepfake to sposób obróbki obrazu wykorzystujący sztuczną inteligencję i uczenie maszynowe do nakładania obrazów ruchomych i nieruchomych na obrazy lub filmy źródłowe. W efekcie mogą powstać na przykład filmy z udziałem dowolnej osoby, która z jego nagraniem nie miała nic wspólnego, a widzowie nie będą w stanie odróżnić oryginalnego nagrania od fałszywego. Materiały stworzone z użyciem tej technologii mogą mieć wieloraki charakter. Zarówno pozytywny, na przykład rozrywkowy czy edukacyjny – w formie spotkania „na żywo” i rozmowy z Salvadorem Dali w ramach wystawy multimedialnej. Jednak mogą również przybrać postać negatywną, w tym dezinformacyjną (tworzenia fake newsów) czy wręcz dyskredytacyjną, których celem jest ośmieszanie czy atak na osoby publiczne, instytucje, a nawet państwa.

W ostatnim czasie techniki deepfake zyskały uznanie wśród twórców serialu „Mandalorian”. Jeden z internautów na swoim kanale YouTube opublikował udoskonalone przez siebie serialowe sceny ukazujące odmłodzonego Marka Hamilla w roli Luke Skywalkera, co spotkało się z pozytywną reakcją twórców serialu, jak i fanów uniwersum. Niestety spora część aktywności wykorzystująca materiały deepfake nie jest tak pozytywna. Obecna technologia i możliwości sztucznej inteligencji umożliwiają stworzenie filmów na tyle wiarygodnych, że staną się one kolejnym orężem dla cyberprzestępców.

Gdy bot może wypowiedzieć wojnę

W ostatnich latach technologia deepfake rozwinęła się do tego stopnia, że obecnie coraz trudniej stwierdzić, czy ma się do czynienia ze sfabrykowanym filmem czy z faktycznym nagraniem przedstawiającym prawdziwe osoby. Przykładami są film z orędziem Elżbiety II czy materiał przedstawiający przemówienie Baracka Obamy, które w krótkim czasie ukazało się na wielu różnych portalach internetowych. Film z wypowiedzą byłego prezydenta Stanów Zjednoczonych dotyczył nomen omen kwestii zagrożeń, jakie mogą spowodować dezinformacja i fałszywe wiadomości publikowane w Internecie. W materiale opublikowanym przez kanał BuzzFeedVideos głosem 44. Prezydenta USA był amerykański reżyser i aktor Jordan Peele. Obecnie jednak sztuczna inteligencja jest w stanie wygenerować głos na podstawie archiwalnych wypowiedzi osoby, która ma pojawić się w sfałszowanym filmie.

Tak zaawansowana technologia może stać się w przyszłości niebezpiecznym narzędziem w rękach cyberprzestępców i oszustów internetowych. Publikowanie filmów z rzekomych wystąpień ważnych polityków może wywołać realne szkody na szczeblu polityki międzynarodowej. Tego rodzaju filmy bazujące na technologii deepfake mogą przyczynić się do powstawania konfliktów i skandali dyplomatycznych, a przez to wpływać na opinie i zachowania społeczne. Filmy z wykorzystaniem deepfake publikowane w czasie trwania kampanii wyborczych mogą z kolei przełożyć się na wyniki wyborów – ocenia Kamil Sadkowski, Starszy specjalista ds. cyberbezpieczeństwa ESET.

Deepfake źródłem fałszywych filmów pornograficznych z udziałem celebrytów

Materiały pornograficzne od zawsze generowały największy ruch w przestrzeni wirtualnej. Nic dziwnego, że technologia deepfake tak szybko odnalazła się w tej sferze działalności Internetu. Według raportu holenderskiej firmy Deeptrace, zajmującej się cyberbezpieczeństwem, aż 96 proc. sfabrykowanych filmów stworzonych z wykorzystaniem technologii deepfake to właśnie treści pornograficzne. Najczęściej do produkcji tego rodzaju materiału wykorzystuje się wizerunek gwiazd kina, sportsmenek a nawet przedstawicielek rządów. Wśród ofiar sfabrykowanych filmów pornograficznych znalazły się w ostatnich latach popularne amerykańskie aktorki, jak np. Scarlet Johansson, Gal Gadot, Natalie Dormer czy Jennifer Lawrence. Chociaż wiele stron, jak np. Reddit, stara się wyeliminować tego rodzaju treści i od 2018 roku serwis usuwa wszelkie nowe filmy i zdjęcia, to wciąż pojawiają się sfałszowane obrazy, których usunięcie ze strefy wirtualnej jest bardzo trudne.

Mimo, że tego rodzaju zdjęcia są sfałszowane i dalekie od rzeczywistości, to w dalszym ciągu mogą zostać wykorzystane na przykład do szantażu lub agresji wobec drugiej osoby – dodaje Kamil Sadkowski.

Technologia deepfake w arsenale cyberprzestępców

Technologia, która umożliwia stworzenie złośliwego obrazu, nagrania audio czy filmu, którego bohaterowie są łudząco podobni do innych osób to szansa na nowy poziom zagrożeń ze strony cyberprzestępców. Szczególnie wobec faktu, że w mediach społecznościowych mogą oni czerpać praktycznie nieograniczone zasoby materiałów źródłowych do tworzenia deepfakes. Oprogramowanie wykorzystujące uczenie maszynowe może przeczesywać np. Facebooka czy Instagram i wyłapywać interesujące zdjęcia czy filmy potencjalnych „aktorów”. Na tej podstawie może stworzyć bardzo wyraźny głos, obraz i film z udziałem danej osoby, ale ze specjalnie spreparowaną fałszywą komunikacją imitującą na przykład znalezienie się w poważnych tarapatach – jako ofiary porwania czy wypadku. W kolejnym kroku wygenerowana zostaje fałszywa prośba o pomoc, na przykład finansową, skierowaną do jej bliskich, czyli ofiar ataku.

W przypadku ataków na firmy technologia deepfake umożliwia stworzenie bardzo realistycznych, fałszywych rozmów telefonicznych, w których przełożony prosi na przykład o zrealizowanie przelewu. W ten sposób w 2019 roku przestępcy wyłudzili 243 tys. dolarów od jednej z brytyjskich firm energetycznych. Innym rodzajem jest atak specjalnych botów wykorzystujący karty podarunkowe. W praktyce wygląda to tak, że bot podszywający się pod szefa instruuje pracownika by zamówił określone karty podarunkowe. Podczas konferencji Black Hat USA 2021, dr Matthew Canham, profesor ds. cyberbezpieczeństwa Institute of Simulation and Training, University of Central Florida, przedstawił badanie, w którym stwierdził, że od czasu pandemii Covid-19 nastąpił wzrost tego procederu o 820 proc..

Wraz z rozwojem i coraz powszechniejszym stosowaniem technologii deepfake, skuteczność ataków tego typu może diametralnie wzrosnąć. Dotychczasowe przykłady pokazują, że deepfake wszedł do arsenału cyberprzestępców, a ochrona przed nim będzie trudna. Istnieją jednak sposoby, by spróbować się uchronić przed tego typu atakiem– mówi Kamil Sadkowski z ESET.

Na podstawie materiałów prasowych oprac. sek

Dziękujemy za przeczytanie artykułu!

Pamiętaj, możesz oglądać naszą telewizję na wPolsce24. Buduj z nami niezależne media na wesprzyj.wpolsce24.